2022年9月8日-9日,在广州南沙经济技术开发区管理委员会指导下,由全球IPv6论坛(IPv6 Forum)和下一代互联网国家工程中心共同主办的2022全球IPv6峰会成功举办,本届峰会以“加速产业生态建设,推进全球IPv6规模部署”为主题,通过线上线下结合的方式面向全球同步直播。

会上,中国工程院院士、推进IPv6规模部署专家委员会主任邬贺铨着重强调了IPv6在算网协同中的重要应用,他提到,“算力作为新型信息基础设施,在云网边端实现计算、存储和网络资源的优化配置。IPv6在算网协同中起到直接沟通、互联和异构连通等关键作用,将全面服务算网协同大发展。”

▲中国工程院院士、推进IPv6规模部署专家委员会主任 邬贺铨

AI加速算力需求

2020年OpenAI发布AI语言GPT-3模型,参数1750亿个,45TB数据,模型大小700G,需要百亿亿次浮点计算,微软专门为OpenAI打造的超级计算机拥有28.5万个CPU核以及1万个GPU,供OpenAI在上面训练所有的AI模型,训练一次的成本大约1300万美元。

2012~2019年,算力需求6年中扩大了30万倍,即每3.5个月翻番。

油气勘探相当于给地表做CT,一个项目的数据100TB~1PB,需巨大的算力支撑。高速列车具有复杂的3D外形和大长细比,很难在风洞中进行1:1模型试验,可在仿真云平台进行数值分析与验证。

电影《阿丽塔》中主角的每一帧画面需要分解为千万个小画面,例如13万根发丝需逐根渲染,800人的团队,动用3万台电脑,整体渲染4.32亿小时,费用超1.7亿美元。

计算任务类型多样性

数据分为热数据和冷数据。热数据,例如远程医疗、自动驾驶、工业互联网等数据,对时效性敏感,适于当地就近处理。

冷数据,例如医疗影像数据需存储15~30年。历史数据有价值需保存但不会频繁调用,适于西部存储。

大块连续I/O密集任务需要快速存储、索引、备份海量异构的Web页面、用户访问日志及属性;提供数据融合和互操作性功能的SaaS应用;需要整合生产各环节大量异构数据的企业商务智能应用,适于采用多线程。

小块随机CPU密集任务,圆周率精确计算、视频编解码等,适于采用多进程。

建模需要用到大数据块,例如油气勘探数据近PB规模,但实时性要求不高。

推理可以只使用小数据块,例如机器视觉的少样本学习、可利用知识图谱、迁移学习、智监督学习等处理的数据,实时性要求高。

算网融合

2022年5月,全球超算第一名能力为1.1EFlops,中国超算数量占全球超算500强的34.6%。

鹏城云脑II现有算力100P,目标1EFlops,商汤智算中心算力将近5EFlops,成都智算中心设计规模达到1FFlops。

按照工信部规划,到2023年国家枢纽节点算力规模占比超过70%。

算力网络是一种按业务需求,在云网边端间按需分配和灵活调度计算/存储/网络资源的新型信息基础设施。

客户按路径远近、算力容量与使用成本及性能等来选择云节点。客户通过通信网络向IDC发出计算请求,利用IDC提供的付费或免费的模型算法、数据和算力,也包括客户自有模型、算法和数据。计算结果通过网络返回客户。

SRv6通过IPv6报头在数据面快速实现路由的组织及云资源调度,成为云网边端算等的统一承载协议,优化网络资源,配置效率可提高60%。

存算分离可采用开放存储体系和磁带存储介质,存储器可池化,同时支持多服务器和多云,高利用率,降成本与能耗。

I/O往复频繁,不适应实时性高的热数据,适于冷数据。

存内计算技术以RAM代硬盘,在RAM内完成所有运算,避免I/O瓶颈,实现复杂且成本高,适于对热数据处理。例如自动驾驶可以在车内同时完成存与算。

数据中心的互联

虚拟机迁移、数据中心云化和并行计算等需要跨数据中心协同;东西部数据枢纽间需要传送冷数据及计算结果;同一数据中心的主备用系统间也需要数据同步和灾备。

数据中心间互联(DCI)方法:

城域网范围,对大客户可基于传输专线提供独占带宽DCI服务,对小客户在IP城域网提供共享带宽的DCI服务,例如MPLS VPN;

对于跨骨干网的互联,运营商传统采用SDH over WDM方式,但容量与灵活性都受限。FlexE over WDM可改进颗粒性。

互联网企业都选择租用裸纤上自建WDM系统的方式来满足100G以上互联需求,考虑到主要是点到点互联,因设备资源无法共享而敏感于成本,同时希望可按需快速部署,开放光互联应运而生。

控制面和数据面解耦,可引入SDN理念实现光网络管控,达到软件开放源代码、接口规范标准、数据模型统一、控制转发分离和网络能力开放的目的。

数据面的光层与电层解耦,光模块采用服务器设备形态,刀片式插拔,以标准接口适配多厂家网络设备,便利扩容,减少体积与功耗。

算力对通信网络的要求

弹性,既要大规模组网适应高吞吐量,又要按需计算,例如气象中心每天需要计算1~2次,每次计算2小时,计算时需要非常大的带宽。

高效,大计算任务需要使用服务器集群,集群内部存在计算协同,当网络有丢包时,增大了因协同等待而产生的时间开销等,使算力持续下降。据实验统计,0.1%的丢包会引起算力损失50%,需要有拥塞通知与避免技术,对于实时性很强的计算在无损前提下还要追求低时延。

感知,需要感知应用需求,为不同的应用提供差异化的SLA保障,还为其中重要的应用提供实时性能的检测,保证用户体验。

安全,数据需要安全输送到算力节点并安全返回计算结果,提供对算力租户之间数据的安全隔离、对外部攻击和数据泄漏防护、终端安全接入等。

经济,优化资源配置,为客户提供最合适的算力接入和使用环境。

低碳,优化调度,降低能耗,使用绿色能源。

算力的调度

很多计算任务具有随机性,虽然天气预报需要每天计算,但是每天也只是集中计算几小时。数据中心的利用率具有潮汐现象,每个数据中心如果按峰值配置,算力利用率显然不高,如能跨数据中心调度,则可获得集约化效益,前提是需要实时感知数据中心的能力。

感知数据中心的算力,数据中心的算力发挥与采用芯片类型(CPU或GPU等)和存算架构有关,例如I/O密集任务与CPU密集任务适于采用不同的架构;存算比过低即存储能力不足也会影响算力的发挥。

感知上层即PaaS和SaaS的能力,配备算法软件不同对计算任务的支持能力就不同,不同的AI任务(卷积网络、深度学习、迁移学习等)所需的软件也不同。例如对于一些Gordon Bell奖的科学工程计算项目,数据中心只有20%的算力可用,计算能力调优是关键。

感知数据中心内部与数据中心间光互联传输系统的实时性能,考虑成本、远近和数据安全等因素。

由于数据中心的业主不同,运营者也不同,算力与网络也很难有统一的操作系统,可利用IPv6地址扩展字段携带的能力可以承载各类感知信息。

IPv6应用感知网(APN6)

传统IP报头仅含源和目的地地址,网络无法识别该IP包承载的业务类型和服务等级(SLA)要求。APN6利用IPv6扩展报头嵌入业务要求,以此为依据来组织信道,未来还可利用IPv6扩展报头嵌入所承载的数据属性,支撑对跨境数据流动的管理。

利用APN,企业敏感数据在本地处理,一般数据上云处理,在多云场景下按APN选最合适云。

同时捕获多路视频的AR需要边缘计算与APN来提供与其带宽、时延、可靠性需求相应的网络服务。

对数据中心而言,希望有反映算力要求的性能标志,而且仅有EFlops还不足以衡量,最好能反映I/O密集型任务还是CPU密集型任务、大文件连续数据块还是小文件随机数据块等。

基于IPv6的随流检测(iFIT)

传统的检测方式采用发送检测报文的间接测试方式,不能保证检测报文与真实业务路径一致,丢包检测精度只能达到10-3。

iFIT(随流检测)技术无需外挂探针,将OAM指令携带在IPv6扩展报头中。根据染色比特经受的时延、误码等来获得链路性能,测量结果嵌入报头的指定字段,处理节点根据报头中的OAM指令信息,收集数据上报。

可检测丢包、时延、路径还原,还可开发对跨境数据流动管理能力。

算力网希望实现任意规模的分钟级全网链路监测,毫秒级虚拟网络拓扑查询。

iFIT可检测IP流通道的性能,但对于上云的应用,IP通道的终点在数据中心服务器的网络层,数据中心内的计算与存储性能需要映射到iFIT字段。

利用SRv6优化接入算力节点的路径

SRv6(分段路由)在IPv6地址扩展头中指定流量转发路径,支持低时延、组播、快速倒换和高可靠并发。

根据应用类型可提供专线产品和网络切片。

基于算力节点位置选择对应的WAN和上云路径。

基于信息安全标识,选择算力节点,保证内部数据安全。

可按需配防火墙/入侵检测路径,为视频会议配加速器。

通过确定性IP控制抖动和保证可靠性

在IPv6报头中新增Flow Label字段,入PE按业务流的QoS要求放行网络可满足该条件的流。同时通过SRv6向入PE下发路径,同一个流的前后数据包需要路径绑定,支持沿途资源预留。

发送时间划分为等长的周期T,数据包按周期进行排队和转发,最大的抖动控制在2T。

SRv6路径规划,云化引擎获取网络状态和报文流的抖动要求并计算路径,对允许接入的流预留资源,形成面向连接的路径。

边缘整形技术,在入PE对一条流的多个报文进行整形,放入合适的门控队列中。

门控调度技术,多个门控用于确定性IP流,每隔10us轮流打开一个门控,小量门控对普通IP流永远开放。

周期映射技术,入PE在T0周期内的报文通过计算转到P1的T2周期,同时加入的还有来自其他入PE的报文。

双发选收技术,为提高可靠性在入PE复制流到另一路径,在出PE择先选取。

SRv6与传送承载

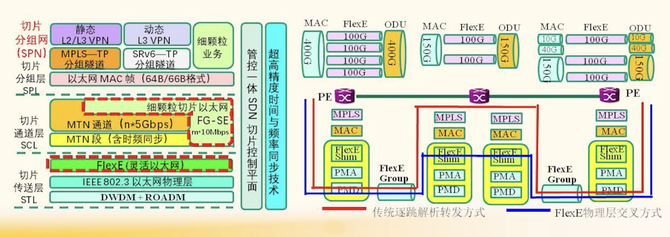

MTN(城域传送网)基于SPN(切片分组网)提供接入网至核心网间多层次多颗粒度的传送承载。

L1以太网,FlexE将MAC层速率适配到50/100/200/400GE的L1,提供信道物理隔离及低时延交叉连接。

L2 TDM,FG-SE将MTN链路5Gbps帧划分为480个10Mbps时隙,也可以10GE接口直接连L1。

L3 IP包,支持MPLS-TP或SRv6-TP的IP包分组数据包传送,实现业务软隔离。

IPv6在算网协同中的作用

互联网选择TCP/IP来屏蔽底层传输系统的差异和支持各类IP化的业务,无需控制面信令,实现不同业主的异构网络即插即用。

IPv6通过对地址的开发进一步发挥数据面互通异构网络的作用,避免了控制面的复杂性和时延。

5G的核心网在分离控制面与数据面功能的同时,强化数据面UPF功能并下沉。

SDN需要用到控制面的功能,但主要是路由和切片的计算。

互联网到现在也没有采用复杂的网络操作系统。

云与网的资源异构,而且面临业主不同难以协调的挑战,云与网很难共用统一的操作系统。

如果算网协同的目的是通过网络调度算力资源,则只需在laaS层互联多云,即IDC间互联,通过开发IPv6地址所承载的数据面网络层功能就可实现,从而无需算网操作系统。

面向算力应用的IPv6需定义和承载该业务流对算力规模的需求和性能;显示数据中心实时可提供的算力、所具有的模型与算法;监测与呈现数据中心间传输链路的性能。

客户的需求与数据中心可供应能力由网络来传递,网络也可据此优化对信道的选择。