【IT168 评论】一年一度“中国系统架构师大会(SACC)”如期召开,主办方IT168网站,集合ChinaUnix和ITPUB社区的专家顾问团将为千位技术达人奉献3天的技术盛宴。2013中国系统架构师大会将围绕“云架构、IT基础架构优化、大数据下的IT架构变迁”三个热点话题展开,首日的主会场已经结束,现场除了火爆以外,我们看到了更多亮点和精华内容。

在网络架构与优化专场由安居客集团技术总监匡萃彪主持,本场技术分享将由来自新浪系统架构师郝光普、快网CEO刘再德、TCPCOPY开源工具开发者王斌、赶集网运维平台开发经理崔华共同分享网络架构与优化之道。

庶民的视频后台架构变迁

首先登台分享的是来自新浪系统架构师郝光普,郝光普表示,“我们团队属于大门户下小作坊里的”高科技“,团队最多时13人,支撑起了视频、共享资料、乐库、电子杂志等业务,本次分享包括三个方面,其一是CDN发展历程、其二直播系统发展、其三存储系统发展。

在新浪视频系统里面最初上线的是播客系统,随着不断的发展,也出现了一些问题,后来根据团队的不断优化,将CDN资源分配为热点资源和非热点资源,并通过修改调度方法,将数据中心、播放接口、用户及其SQUID进行优化,效果很明显,郝光普最后表示,”我们最后升级了硬件服务器,CDN效果得到了进一步提升,因此系统优化是一方面,同时硬件设备升级也是很重要。“

在新浪上线的第一代直播系统是FMS,在使用一段时间后,进行了相关优化,将RTMP、切片存储、PC用户/iOS用及索引服务进行优化,实现了点播直播混合播放,随后上线了第二代直播系统OVS,本次升级将文件、RTMP、 TS UDP、SDI通过转码系统链接到索引和媒体文件,做到了实时转码,最后通过优化CDN转发给PC用户/iOS用户,同时用户也可以通过索引来播放视频。

在新浪视频存储系统第一代系统是通过FILE分发给分发库、资源库、d0,然后再通过分发接口和播放接口给到播放器,分布式文件系统中,Red Hat GFS虽然具有Data集中存储,MetaData分布的特点,但是不适合数据量大的应用;使用Google GFS、MooseFS、HDFS具有Data分布存储和MetaData集中存储优点,困扰是1、解决MetaData单点方案或复杂或不可靠2、处理百亿级文件出现性能瓶颈3、跨IDC部署难,最终打造了分布式文件系统SSP来存储。

企业典型网络架构与网站优化

在新浪架构师郝光普刚才的演讲中,多次提到CDN优化,那么纠结该如何做呢?由来自快网CEO 刘再德为我们分享企业典型网络架构与网站优化的精彩分享,通过概述、网络架构选型、网站优化策略、监控分析模板及最后快网的解决方案分享。

面对当前互联网迅速持续增长,刘再德表示,“截至2013年6月,我国网民规模达5.91亿,家庭宽带4.64亿,互联网普及率达44.1%。大大小小的公司的业务也普遍融入到互联网中,目前国内共有网站294万,面对异常激烈的业务竞争,网络构建及优化更显得尤为必要,当前用户要求网页在2s内打开,否则就会关闭网页”。

对于微型、小型、中型公司CDN架构如上图,大型公司的网络架构CDN一般采用BGP+分布式IDC+CDN,同时根据业务情况选择自建CDN或者采用商业CDN,这些客户包括汽车之家、世纪佳缘等。倘若是巨型公司网络架构,则会采用BGP+分布式IDC+DIY CDN+商业CDN,自建CDN可以量体定制,更适合自身业务发展;安全可控,我的安全我负责;管理紧耦合,高效的CDN的管理;节省成本,内容价值可控;业务提速,提升服务品质,公司业务一般是全球化,这些客户包括新浪、淘宝、腾讯等。

关于网站的优化策略,刘再德表示,“网站的优化十分重要,良好的用户体验可为企业带来巨大的收益,解决各个环节的问题诱因,成为必不可少的优化途径。各环节主要包括,网络问题、DNS问题、HTTP问题、网页问题、访问者客户端问题。”

由于互联网best-effort的服务属性,决定了其服务的不确定性,即便再好的传输环境,也需要监控及数据分析的支持。自建站点监控主要是监控,服务器状态(cpu、内存、硬盘)、Web服务状态(端口)、监测页面返回状态、服务器流量情况、远程连接控制。

对于大型网络则需要6个层次交叉监控,包括网络监控: 网络速度, 链接健康;物理监控: 服务器内部情况,监控方法检测CPU、 内存、 IO、 硬盘、 SWAP; 负载流量监控: 每台服务的流量,监控方法: MRTG;局网监控: 每个交换机监控,监控方法: 交换机流量, 状态;源站监控: 源IP, URL,监控方法: ping, URL;服务监控: 客户服务总流量的变化,监控方法: 统计数学上的连续性, 相似性,最后分享了快网的解决方案及许多免费工具和服务。

孤独开发之路 tcpcopy架构漫谈

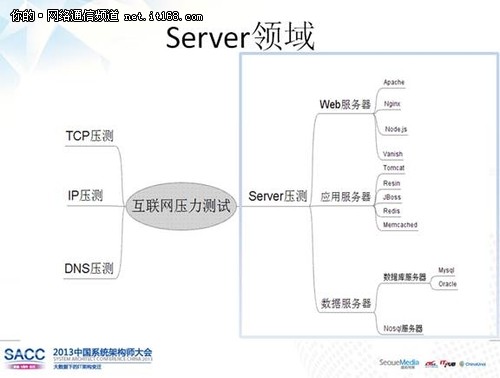

在两位技术大牛分享了架构搭建、CDN优化之后,那么搭建完成的系统能否完全支持未来海量压力呢?这个问题将由tcpcopy架构创始人王斌来分享在海量在线业务系统的分布式压力测试实践,王斌表示,“黑客的洪水攻击其实是最好的压力测试,我将会给大家分享压力测试背景、压力测试挑战、Server应用特点、底层旁路、压测实战。”

谈到压力测试,很多人都会说压力测试能否反映真实在线的情况?,传统压力测试由于测试环境和因素,导致大量潜在应用BUG无法被暴露,想要获得真实的数据,就必须利用真实数据来测试,离线方式可以采用log回放,在线方式可以在服务器端集成旁路功能,带来的挑战就是要对在线系统性能影响小、不影响在线业务、支持长期测试,最总获获得真实测试数据。

关于Server应用的特点:大部分都是客户端发起链接请求、不会满负荷工作、分为面向外网的应用和面向内网的应用、大部分应用是TCP应用、大部分应用是不安全的,没有走SSL或者TLS、绝大部分部署都在同一LAN或者高速网络内。该如何测试呢?通过对各种方案对比,得出从底层旁路出应用层的实时回放是一个不错的方案,非常好的旁路入向方案是采用硬件底层旁路设备+LVS组合。

遥望灯台前进路 运维的登月之旅

在前面三位技术大牛分享了架构搭建、CDN优化、压力测试,那么最后如何快速将新的业务系统上线呢?来自赶集网的网络架构师崔华来分享他们的APOLLO(阿波罗)平台-赶集的运维登月之旅。

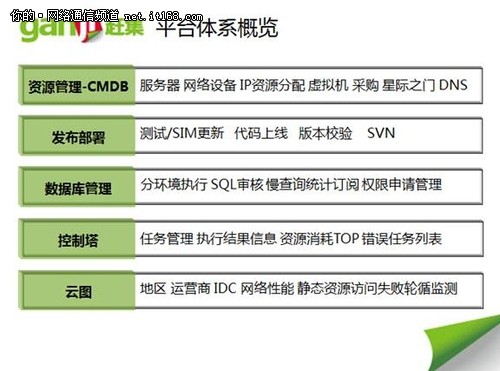

为了解决每天几十个新业务上线、几十次次数据库操作和不计其数计划任务调度,赶集网打造了这套APOLLO(阿波罗)平台,主要解决了发布上线、数据库管理、控制塔、云图4大功能。

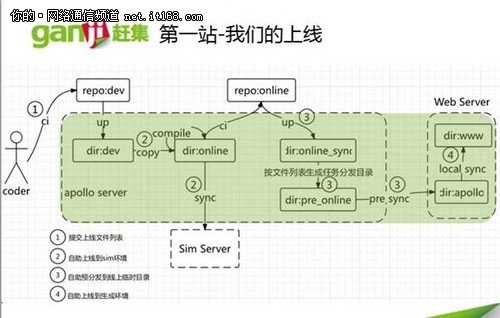

传统上线全部是手工操作、沟通频繁、等待排队时间长,新的发布平台将由DEV->QA->SIM->ONLINE,由开放者发起上线请求,负责人确认后进行测试后预发布,成功后正式上线,包含的技术点有编译压缩、预先分发、同步更新,优点是无需排队 自动执行、 轻松查看 减少沟通、压缩合并 完全透明、运维开发 彻底解放。

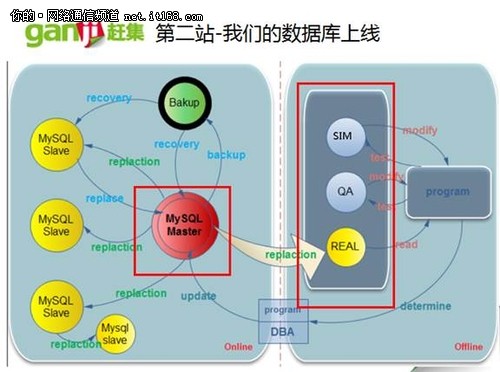

传统数据库管理主要是手工操作、沟通频繁、风险很大等因素,为加快管理简化操作流程为,页面、提交、审核、操作,操作类型包含修改、导数据、申请,非常好的技术点谁提交操作风险谁控制,最终实现SQL上线 轻松自助、库表创建 规范语法、数据导出 预约操作、权限申请 审批快捷。

传统使用使用crond进行任务调度,不仅任务量多 难管理、执行结果 难获取,而且报警通知 难触发等众多问题,为此打造了控制塔(ControlTower),通过流程化,将监控实时展示,能够很好的展示,为实现云图奠定基石,通过云图界面,将全国各城市访问赶集网的耗时统计,基于IDC/运营商维度访问耗时统计,不可达用户IP等信息收集,客户端连接,解析,加载等时间的统计。

更多关于SACC 2013相信信息及PPT、采访视频请点击